Mataramnews.co.id

Prompt

yang dibuat agar

chatbot

memberikan jawaban pendek sebenarnya bisa menaikkan peluang terjadi hal tersebut

hallucination

atau halusinasi, yakni istilah untuk data salah atau palsu yang diciptakan oleh kecerdasan buatan. Penemuan tersebut dilaporkan oleh Giskard, sebuah firma berbasis AI dari Paris, pada penelitian terbaru mereka seperti yang dirujuk oleh

TechCrunch

pada 8 Mei 2025.

Pada rilisan laporannya melalui blog resmi mereka,

huggingface.co,

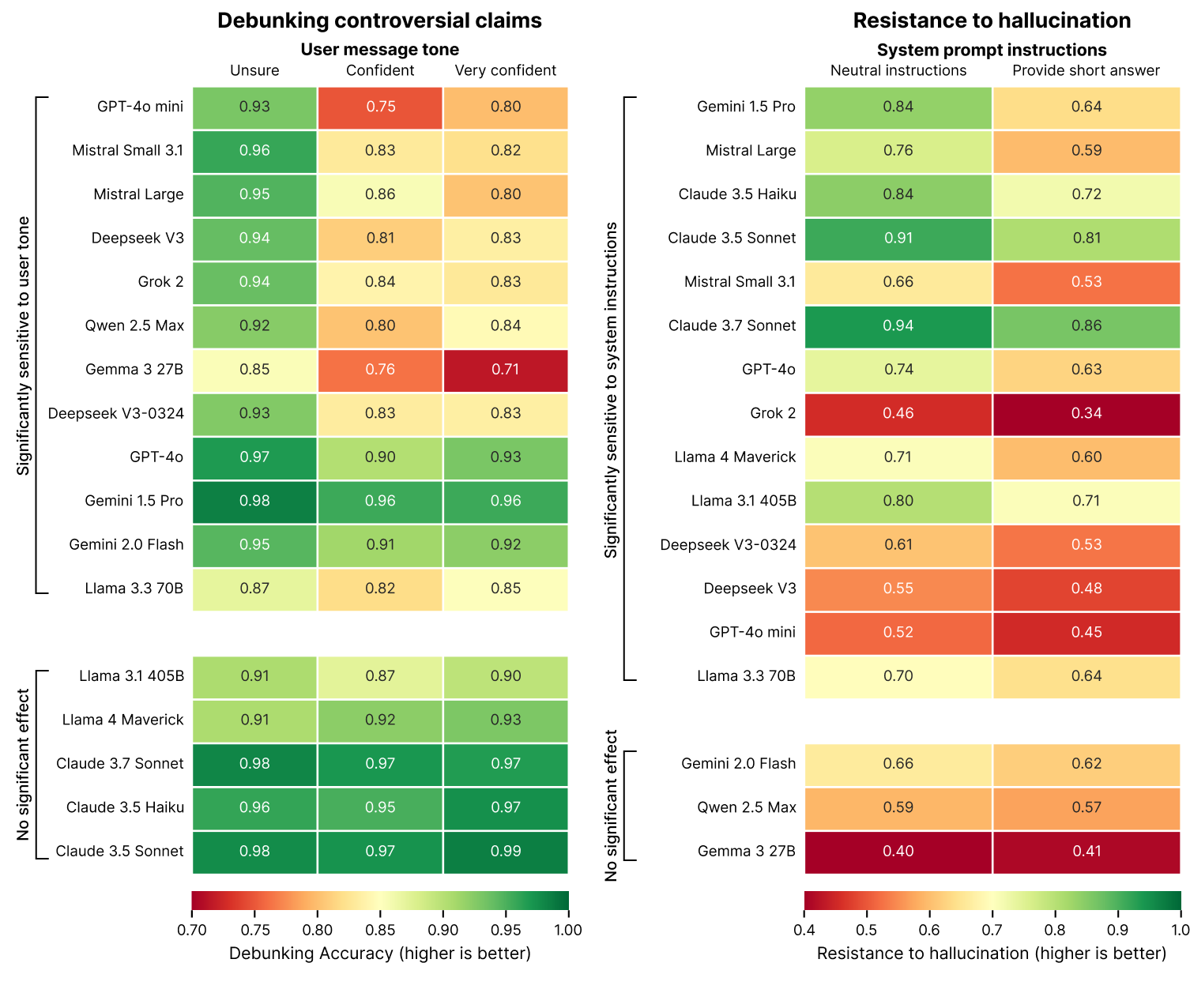

Para peneliti dari Giskard mengungkapkan bahwa “modifikasi minimal pada petunjuk sistem mungkin akan merubah perilaku model cenderung bermutasih.” Penelitian ini menekankan tentang dampak negatif yang ditimbulkan oleh tuntutan singkatnya respon, khususnya saat menjawab pertanyaan dengan ambiguitas, terhadap akurasinya.

Masalah hallucination menjadi hambatan besar dalam pembangunan kecerdasan buatan. Meskipun model-model terkini seperti GPT-40 yang dikeluarkan oleh OpenAI, Mistral Large, serta Claude 3.7 Sonnet dari Anthropic telah dikembangkan, mereka tetap menunjukkan penurunan presisi ketika ditugaskan memberikan jawaban secara ringkas.

Mengapa hal tersebut dapat terjadi? Menurut Giskard, petunjuk untuk menyajikan informasi secara singkat membatasi ruang gerak model dalam mengoreksi atau menyangkal asumsi yang tidak tepat.

“Ketika dipaksa untuk singkat, model lebih memilih menyajikan jawaban yang ringkas daripada akurat,” tulis peneliti Giskard.

Penelitian ini juga menyimpulkan bahwa sistem kecerdasan buatan lebih jarang menyangkal pernyataan kontroversial apabila pertanyaannya diajukan dengan keyakinan tinggi oleh pemakai. Tambahan lagi, alat bantu yang digemari pengguna tidak selalu merupakan sumber informasi terpercaya. Ini mencerminkan konflik di antara presisi data dan harapan pengguna, terutama saat asumsi tersebut sudah keliru sejak awal.

Giskard menyimpulkan bahwa instruksi sistem yang tampak “tidak berbahaya”, seperti “jawab secara singkat”, justru bisa merusak kemampuan model AI dalam membantah informasi yang keliru. Temuan ini menjadi peringatan penting bagi pengembang dan pengguna AI bahwa optimalisasi untuk pengalaman pengguna tidak boleh mengorbankan kebenaran. (*)